En 2013, c’est Damien Chapoulart qui m’avait glissé le petit livre d’Ivan Illich dans le sac. On était dans le garage transformé en bureau du GDA Cru Banyuls, tous les deux accompagnés dans la découverte de la viticulture du cru par Eric Noémie. Damien m’avait dit « ça te parlera », avec un regard entendu.

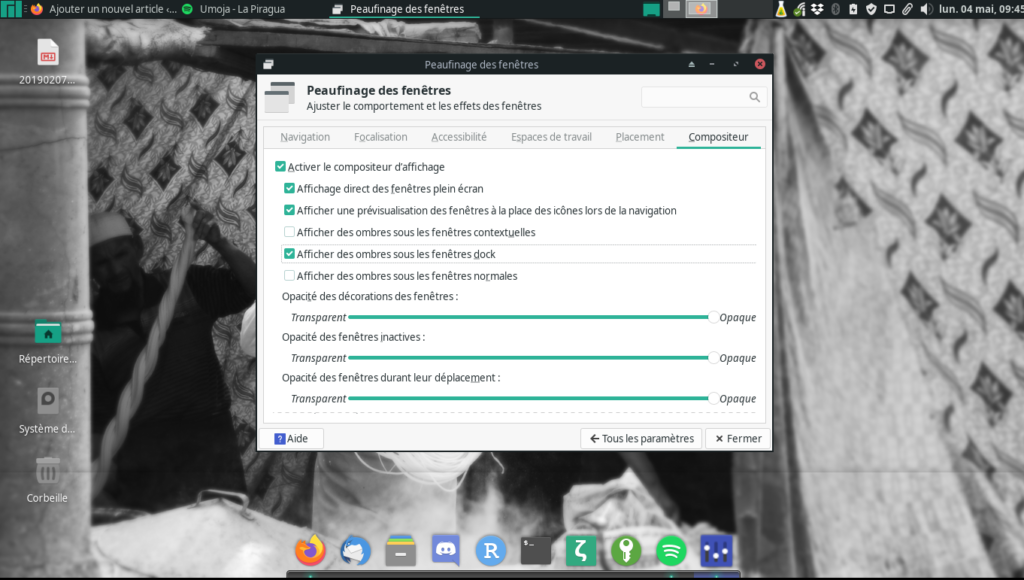

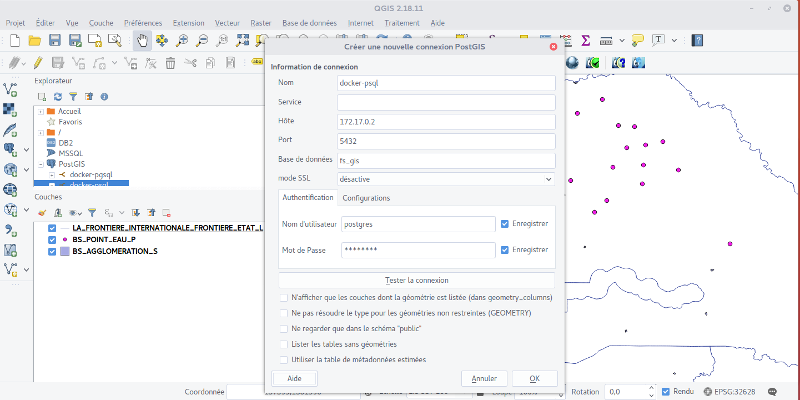

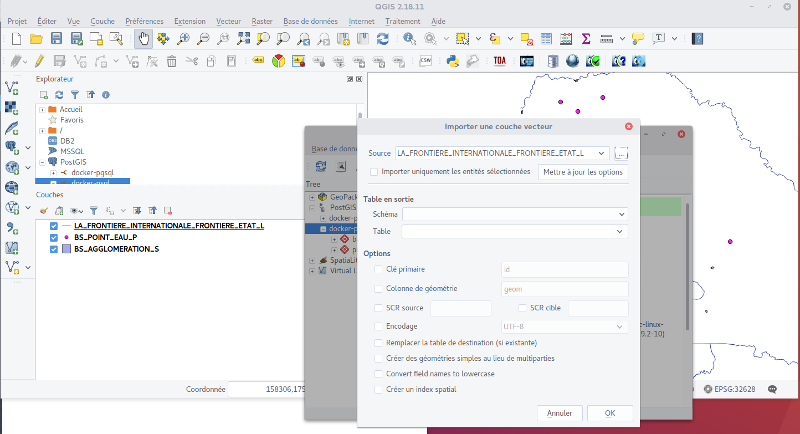

Il avait tellement raison ! À l’époque on travaillait sur des questions de température et d’ensoleillement des zones viticoles sur GRASS-GIS. GRASS-GIS est un logiciel de traitement de données spatiales extrêmement puissant, mais connu pour la rugosité de l’interface.

La convivialité comme fermant du pharmakon

À la lecture de « La convivialité » (1973), j’avais été frappé par l’actualité de la pensée d’Illich. Il s’y oppose à la domination des institutions et des technologies sur la vie humaine et plaide pour des outils et des pratiques qui favorisent l’autonomie et les relations interpersonnelles. Un outil convivial est celui qui permet à l’utilisateur de réaliser ses intentions sans dépendre d’experts ou de structures hiérarchiques. Pour lui, la technologie doit donc rester au service des hommes, où les utilisateurs ont le contrôle et peuvent participer activement à la production et à l’entretien des outils. Il y décrit, le travailleur dans son atelier qui organise son espace en fonction de son vécu, et la dépossession de son lieu de travail quand l’ergonome impose une place aux outils pour lui faire gagner du temps.

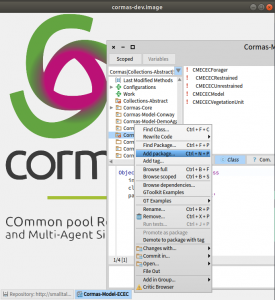

Le lien avec le logiciel libre m’avait sauté aux yeux. Un code source ouvert, qui permet aux utilisateurs de pouvoir se saisir de l’outil ! Je l’avais proposé en ouverture du FOSS4G-fr en 2016, puis dans la préface de « Introduction à la géomatique » de Nicolas Roeland en 2019, commise avec mes complices Simon Georget et Didier Richard.

Malgré son image de logiciel jamais vraiment fini, réaliser par des hobistes, les logiciels libres ont, petit à petit, réussi a estompé cette image à l’exemple de GIS (une pensée émue pour GRASS et Qgis en 2010). Pourtant, cette austérité, nous dit Ivan Illich (1973) « n’a pas vertu d’isolation ou de clôture sur soi. Pour Aristote comme pour Thomas d’Aquin, elle est ce qui fonde l’amitié. […] Thomas d’Aquin définit l’austérité comme une vertu qui n’exclut pas tous les plaisirs, mais seulement ceux qui dégradent la relation personnelle ». L’austérité devient le moteur de la « société conviviale […] où l’outil moderne est au service de la personne intégrée à la collectivité, et non au service d’un corps de spécialistes. Conviviale est la société où l’homme contrôle l’outil. »

Survivre dans un monde dominé par Windows

En passant à Linux il y a plus de 10 ans pour des raisons politiques auxquelles Illich n’était pas étranger, j’avais expérimenté la difficulté d’exister dans un monde qui s’échange des fichiers de MSOffice.

On ne compte plus le nombre de situations embarrassantes dans lesquelles on se trouve quand on doit travailler sur un doc commun et que je fais sauter la mise en page parce que je l’ai ouvert avec OpenOffice ou libre Office.

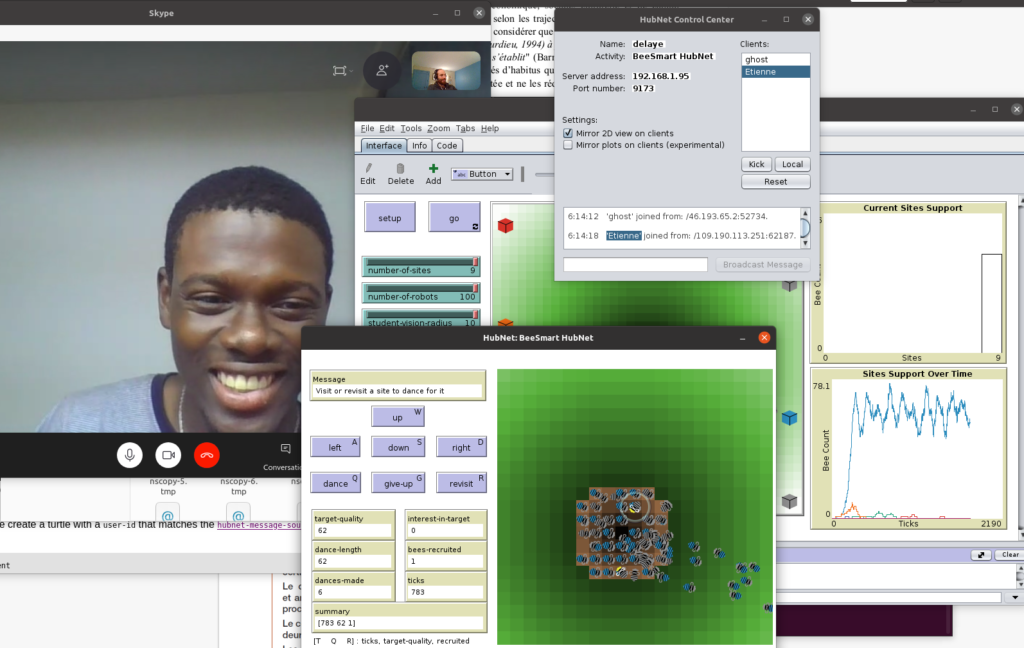

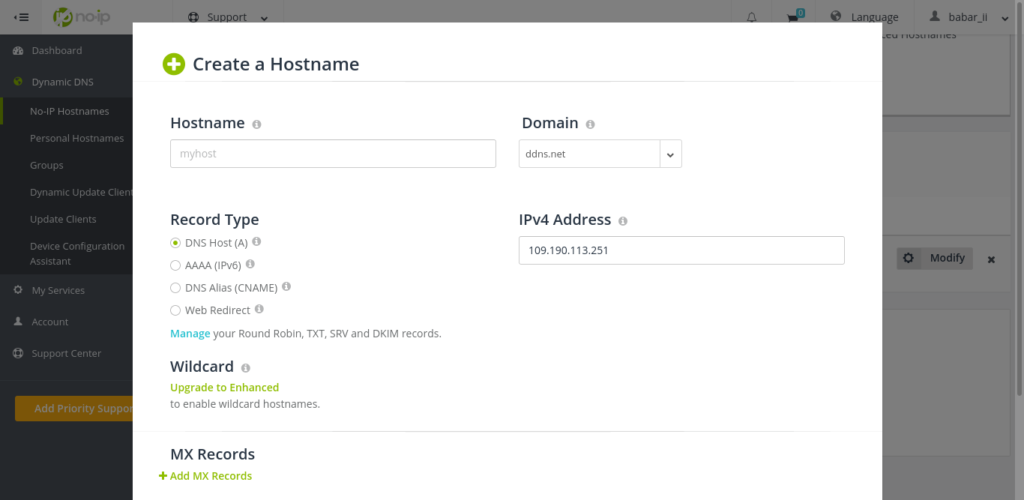

Vous me direz c’est le temps que stabiliser un réseau de pratiques. Par exemple, quelle fluidité de travailler avec la Team OpenMole (ou le libre n’est pas une option). Pour les autres, on trouvait des astuces. Pour remplir les ordres de mission par exemple, j’avais monté une VM pour mon unité de recherche avec Windows installé dessus, pour permettre au non Windows de remplir ces tâches administratives.

La circulation se faisait, on bricolait des ponts. Comme tout bricolage, ça nécessite de monter en compétences techniques, ce qui peu à peu initie une forme d’hybridation. Une manière « d’être au monde » et de faire un monde qui n’est pas enfermé par la technique.

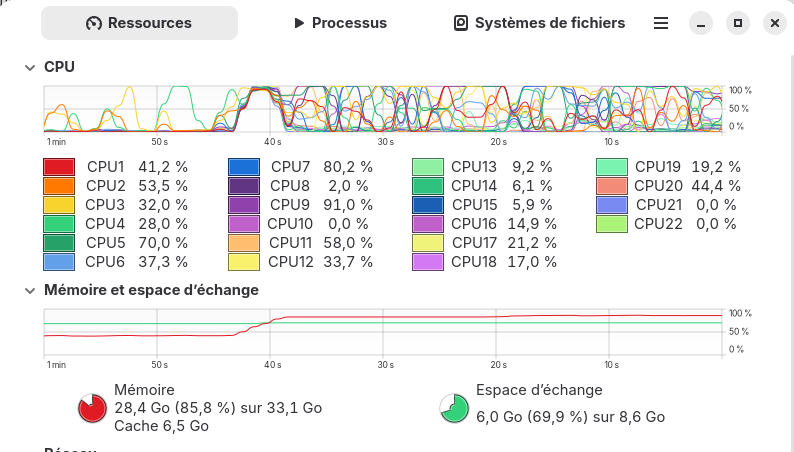

Et sont arrivés les LLM (Large Langage Model) et GPT (Generative Pre-trained Transformer). Là, toutes les frontières ont sauté aussi bien hardware que software ! Logitec a intégré des boutons sur ses claviers pour raccourcir l’accès à ChatGPT, des raccourcis sont aussi disponibles dans les extensions de Thunderbird … et Microsoft propose d’introduire l’IA dans sa prochaine mouture de Windows. Il y a un incontestable effet « wouahou » qui s’empare de tout le monde. Et des effets de bord (pour le moment) dont on identifie pour le moment mal les retombés.

IA Générative et environnement de travail

Sans le dire, sans en discuter collectivement, l’IA chamboule donc beaucoup de pratiques issues d’une co-évolution plutôt « longue » à l’échelle du numérique. On arrive à un point où il me semble que l’intégration de l’IA repose complètement des question de maitrise de nos environnements de travail et de nos vies.

C’est là que Günther Anders entre dans la danse. Dans « L’Obsolescence de l’homme », il utilise le concept de friction pour décrire la résistance qui empêche l’intégration parfaite des humains dans le monde technologique. En abordant la friction dans ce contexte, Günther Anders ne pointe pas simplement un problème technique, mais met en lumière une question philosophique et éthique profonde. Il avertit que sans aborder cette friction, l’humanité risque de devenir obsolète, incapable de maintenir le contrôle sur les technologies qu’elle a créées.

Un thème qu’on retrouvera dans « Rêve des machines » (trad. 2022 ed. Allia), il annonce p. 71 « il est maintenant bien clair,[…] que le principe dont je parle, à savoir la tendance à un expansionnisme sans limite et à un intégrationnisme total, est inhérent à la technique en tant que telle ; que ce principe ne gouverne pas uniquement les pays généralement regroupé tant bien que mal sous la dénomination d’État totalitaire. » La technique de par son expansion s’étend sans distinction politique. Et la vitesse de son extension joue aussi un rôle dans la friction et obsolescence. Alors que le monde s’accélère, l’Homme n’as pas le temps de s’hybrider.

Or c’est bien le propos d’Yvan Illich dans « la convivialité » tout l’enjeu est dans le choix, et la possibilité de conserver ce choix dans le temps. Un choix individuel, qui repose sur son propre consentement à l’hybridation avec l’IA, et un choix collectif, qui lui repose sur l’acceptation ou non de permettre un post-traitement des photos, des enregistrements audio, etc… parfois sans véritablement s’en rendre compte. Ce questionnement devient encore plus prégnant quand on considère l’éco-système privé et privateur de liberté qui est en train de se construire. Il y a donc comme avec le logiciel libre un enjeu à soutenir et accompagner le développement d’IA libre et suffisamment frugale pour tourner sur des machines personnelles.